アニメ絵を高精度の実写系画像に変換してみます。実写系画像では出しにくいコスチュームやシチュエーションもアニメ絵なら出しやすいケースがあります。そういうときは一旦アニメ絵で出したあと、multicontrolnetでreference onlyとtile resampleを併用して、高精度の実写系モデルを生成できます。今回は実写系で大人気のBrav5モデルを使って、アニメ絵を実写画像に変換する条件をいろいろ探ってみました。

準備1:ControlNetやモデルなどの準備

今回、変換にはControlNetのreference onlyを使います。古いControlNetには入っていませんので、ControlNet1.1.153以降にアップデートしましょう。(参考記事:reference only Controlで学習なしで好きなキャラを出す:Stable Diffusion ControlNet拡張機能)

また、openposeとtile resampleも使うので、ControlNetのモデルをダウンロードしましょう。(参考記事:進化したControlNet1.1のレビュー(Stable Diffusion Web UI))

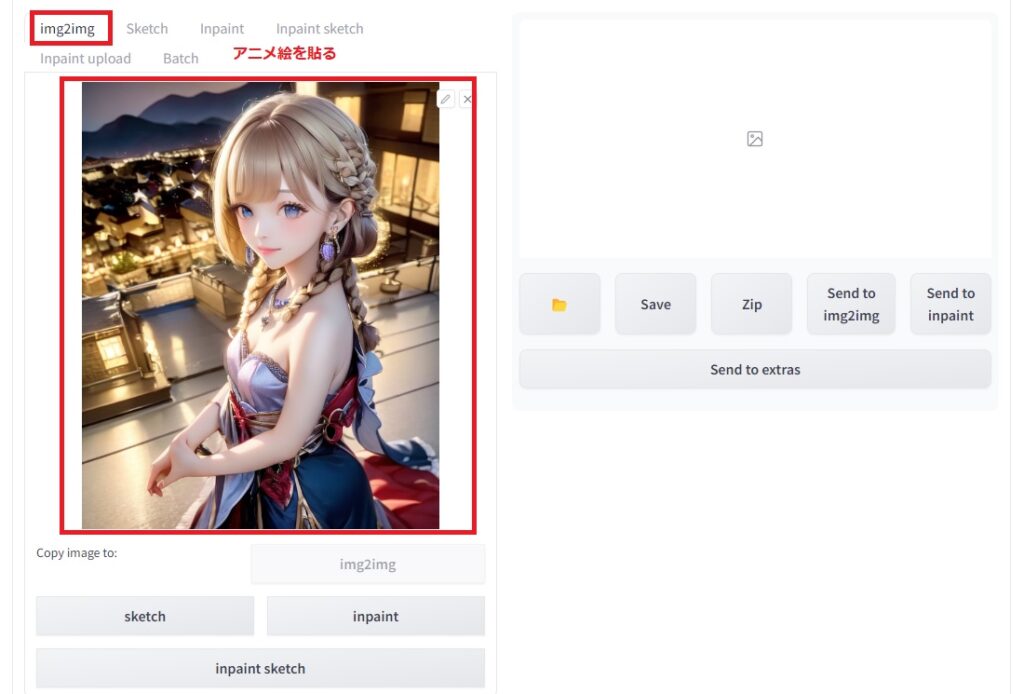

また、今回、変換元の画像はアニメ系モデルから生成した画像を使います。好きなアニメ系モデルで画像を作っておきましょう。もし、生成した画像以外のものを使いたい場合は、タグ付けのためにTaggerをインストールしておくと便利です。(参考記事:WebUIのTagger拡張機能で画像のタグ付け)

また、今回、実写系モデルのbrav5を使います。brav5はCivitaiからダウンロードできます。その他の実写系モデルでもよいので、入手できるものを使いましょう。使用にあたっては注意事項を守って使いましょう。

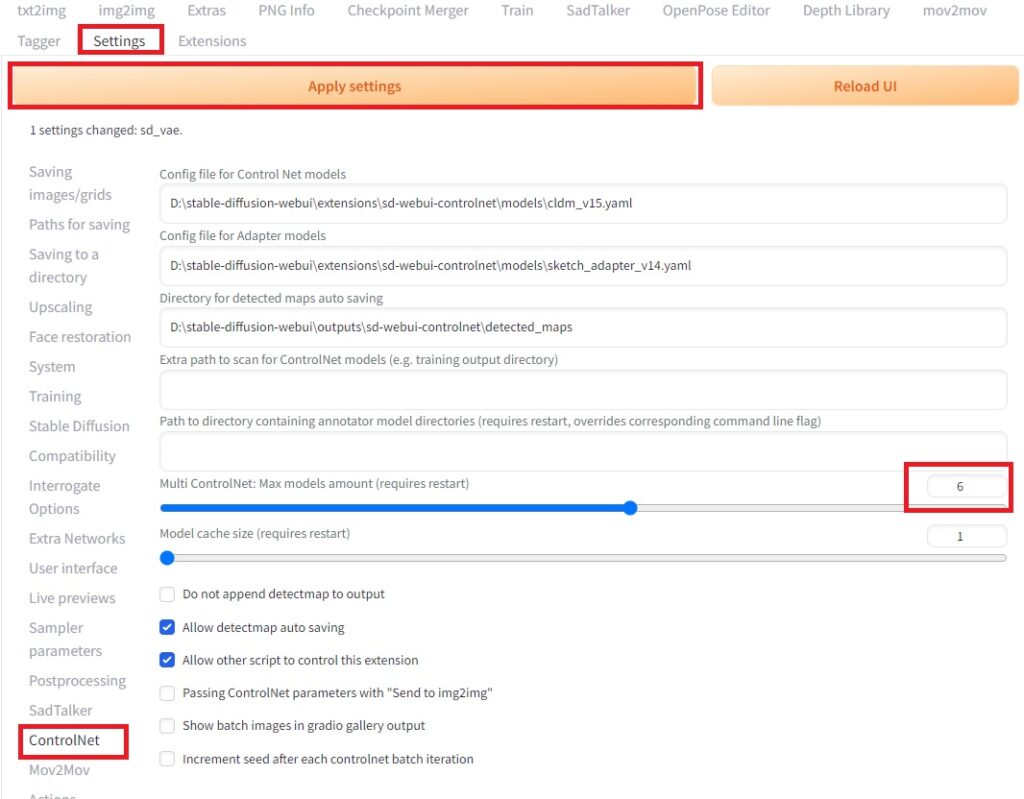

準備2:MultiControlNetの設定

今回、一度に複数のControlNetを使えるMultiControlNetを使用します。MultiControlNetを使うには、SettingsのControlNetの中の「Multi ControlNet: Max models amount」を3以上に設定しておきます。「Apply settings」のボタンを押してからStable Diffusionを再起動しましょう。

アニメ系画像→実写系画像の変換

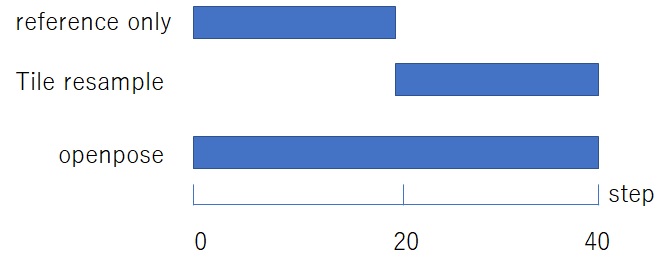

もっと良い変換方法があるのかもしれませんが、結構うまくいった例を示します。どうやってもある程度の変換はうまくいくのですが、生成画像のクオリティを上げるポイントは前半はreference onlyで元のテーストを維持しつつ、後半はtile resampleでbrav5の性能を存分に引き出すところにあります。openposeはスタイルの一貫性を保つために入れていますが、なくても大丈夫です。

以下、私のやった設定方法を示します。

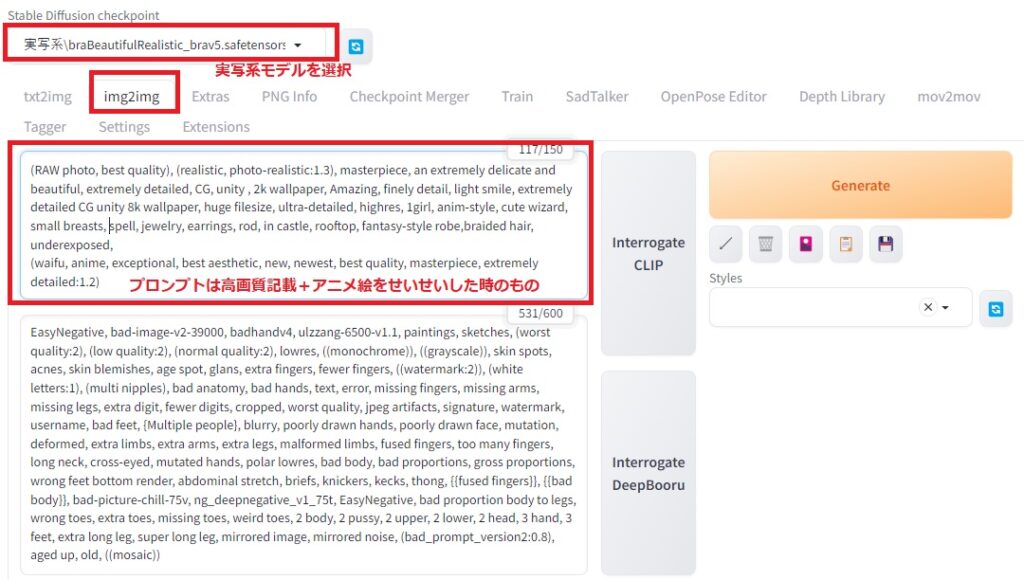

・img2imgを使う

・brav5などの実写系モデルを使う。

・プロンプトは高画質記載とアニメ絵を出した時のプロンプトを併用する。

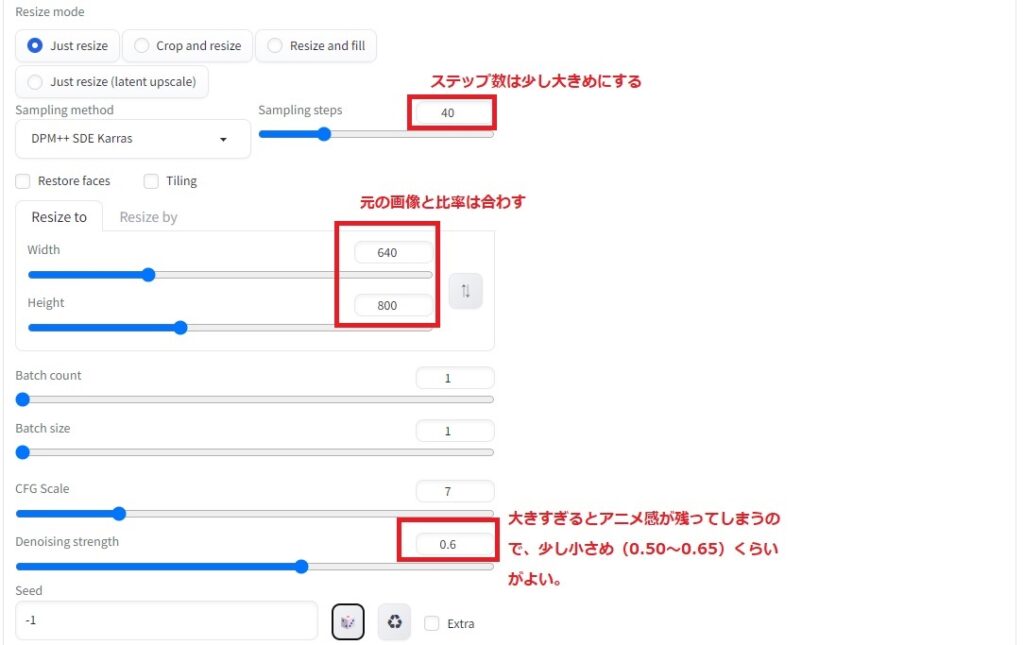

・ステップ数は前半と後半でcontrolnetの種類を変えるので、大きめの40に設定する。

・画像の比率は元の画像と合わす。

・Denoising Strengthは大きすぎるとアニメ感が残ってしまうので、少し小さめの0.50~0.65くらいに調節する。

・ControlNetは3種類使う。

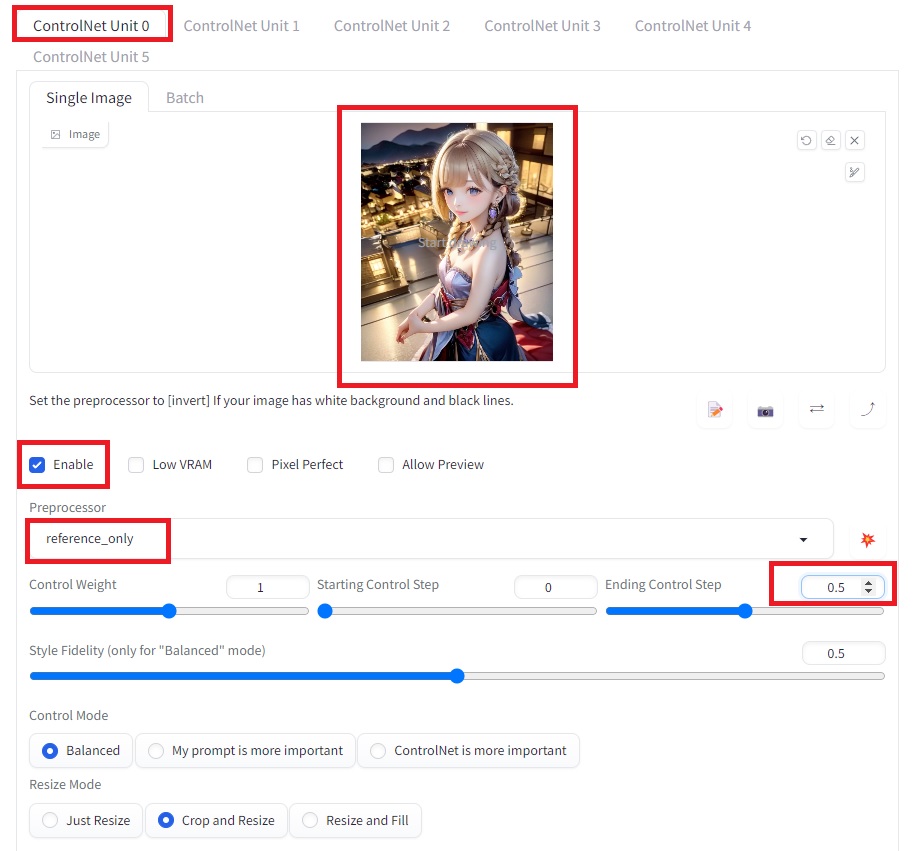

・ControlNet Unit0:reference onlyでEndingControlStepを0.5に設定する。

・ControlNet Unit1:tile resampleでStartingControlStepを0.5に設定する。

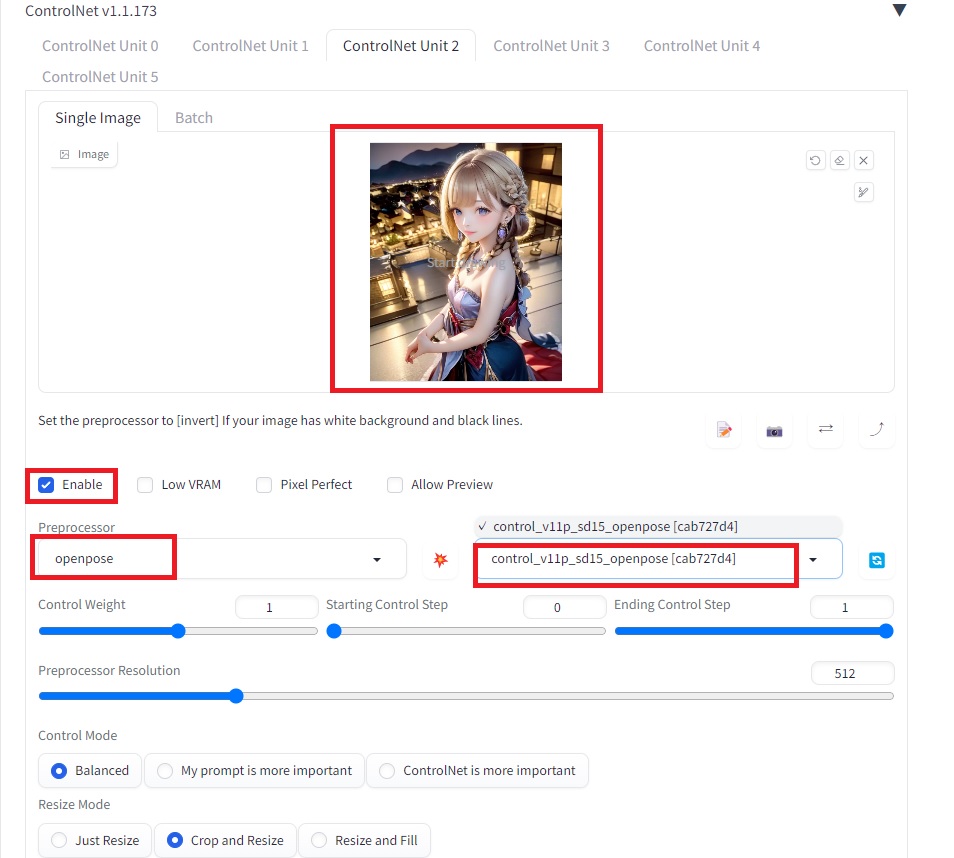

・ControlNet Unit2:openposeに設定する。

・つまり、前半はreference only、後半はtile resampleを効かして、全体にopenposeを掛けます。

変換前後での画像の比較

下にいろいろなアニメ絵の変換例を示します。いかがでしょうか?

前の画像:元のアニメ画像 次の画像:brav5で生成しなおした実写系画像

コメント