EasyPromptAnimeはAnimateDiff prompt travelを改良したアプリで、Zuntanさんが開発したアプリです。実装が初心者にも分かりやすく、アップスケールやフレーム補完を実装しているので非常に簡単に使えます。ここでは、これからEasyPromptAnimeを使って動画を作ってみようという方に私がやってみた設定例をご紹介します。

EasyPromptAnimeのセットアップ

EasyPromptAnimeのセットアップ方法についてはZuntanさんのGithubで詳しく説明してくれています。ここに書かれているとおりやればセットアップできると思います。

ただ、見ても良く分からないと方に向けて少し補足します。(良く分からずにインストールするのは本来は良くないので、自己責任でお願いします。。。)

前準備

・Python3.10とGitをセットアップします。(PythonとGitのセットアップの方法はこのリンク先の記事でも説明しているのでご参考ください→Stable Diffusion WebUIをPCローカル環境へのセットアップ方法(2023年8月最新版)

・もし、C:\Windows\System32にPATHが通っていない場合は次の記事をご参考ください。→WindowsでPATHを通す方法

インストーラーのダウンロード

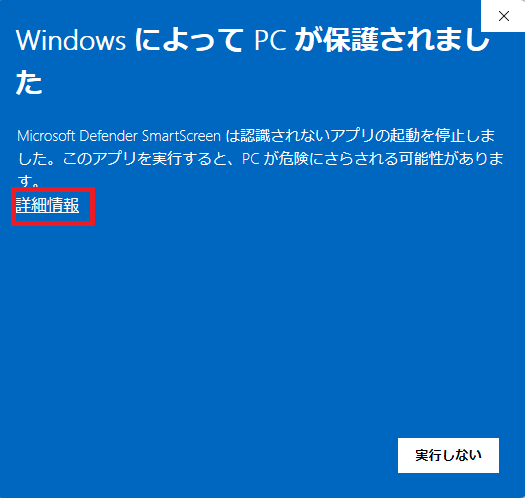

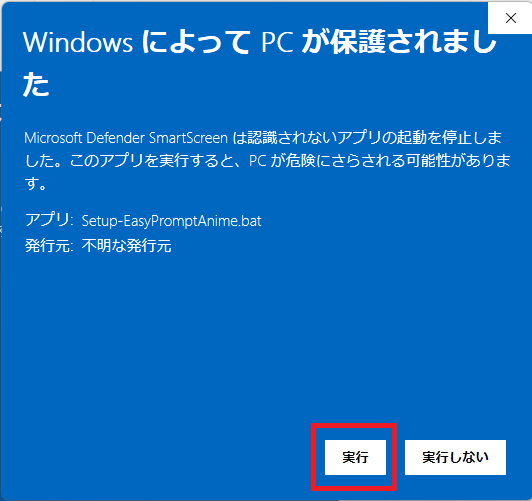

インストールするフォルダを作成して、その中にSetup-EasyPromptAnime.bat を右クリックで「名前をつけてリンク先を保存」でダウンロードします。ダウンロードした「Setup-EasyPromptAnime.bat」をクリックして実行します。その際、下のセキュリティ警告が出た場合は、詳細情報から実行をクリックしてください。

・セットアップには非常に時間が掛かるので気長に待ちましょう。

・Civitaiからダウンロードするモデルがあるそうので、Civitaiが不安定な場合はセットアップが失敗することがあります。

・インストールするフォルダのPATHには日本語が含まない場所で、ドライブ直下が良いです。

・ストレージは私の場合で約40GB近く必要でした。そのあとの生成時にもストレージは必要となるので、余裕のあるストレージを使いましょう。(足りない場合はSSD増設をおすすめ→Stable Diffusion用にSSDを増設してみた)

EasyPromptAnimeの使い方例

詳しい使い方はZuntanさんのGithubを参照してください。ここでは、私の生成例を示しますので、ご参考ください。

モデルのアップロード

モデルは「\animatediff-cli-prompt-travel\data\models\sd」のフォルダの中に入れます。VAEとマージしたモデルが推奨されているようです。モデルによっては使えません。今回使うモーションモジュールがSD1.5系なので、SD1.5系のモデルを使います。ここでは、日本人風のAI美女生成に定評がある佐城郎画氏が作ったマージモデル「BracingEvoMix_v1.safetensors」を使います。

生成設定ファイルの作成

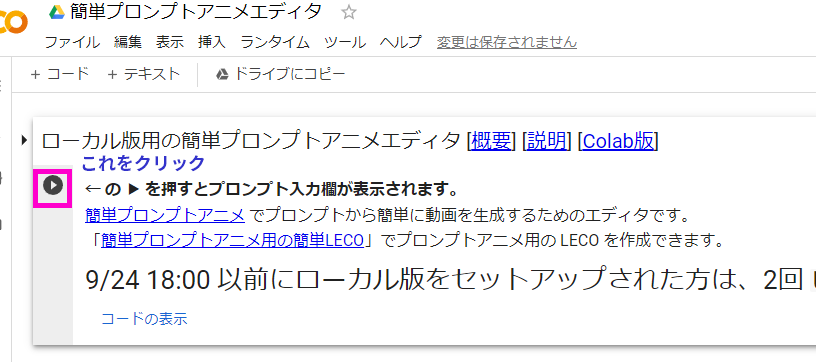

JSON形式の生成設定ファイルを作成します。手動でも書けますが、Zuntan氏の作成してくれたGoogleColabの「簡単プロンプトアニメエディタ」を使うのが便利です。エディタの開くには左のリンクを開くか、「OpenClabEditor.bat」のファイルをクリックして起動します。

まず最初に下のボタンを押すとプロンプト入力欄が初期化されてプロンプトのひな型が表示されます。

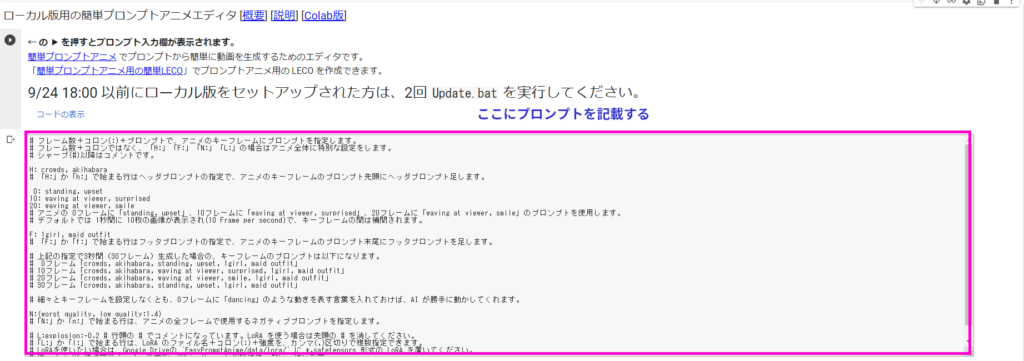

以下がプロンプト入力欄が開いた状態です。

プロンプトは「固定のヘッダプロンプト」+「アニメ用プロンプト」+「固定のフッタプロンプト」から成ります。また、それに加えて、「固定のネガティブプロンプト」があります。

「ヘッダプロンプト」は「H:」に続いて、「フッタプロンプト」は「F:」に続いて入力します。また、「アニメ用プロンプト」はキーフレーム毎に適用したい画像生成プロンプトを入れます。その時に動きを表すプロンプトを入れることによって、フレーム間をその動きで保管してくれいます。

以下に私の入力例を示します。(「#」以下は便宜上消していますが、無視されるので消さなくても良いです。)

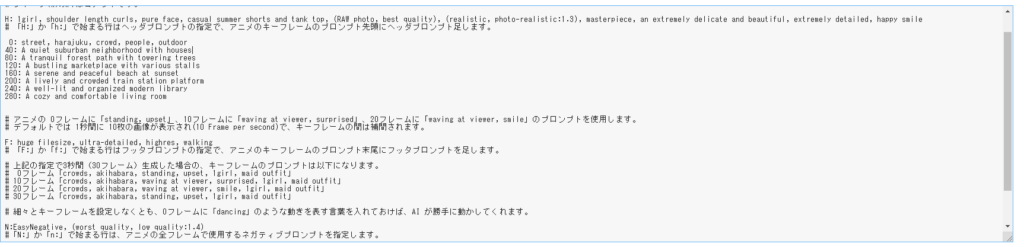

H: 1girl, shoulder length curls, pure face, casual summer shorts and tank top, (RAW photo, best quality), (realistic, photo-realistic:1.3), masterpiece, an extremely delicate and beautiful, extremely detailed, happy smile

0: street, harajuku, crowd, people, outdoor

40: A quiet suburban neighborhood with houses

80: A tranquil forest path with towering trees

120: A bustling marketplace with various stalls

160: A serene and peaceful beach at sunset

200: A lively and crowded train station platform

240: A well-lit and organized modern library

280: A cozy and comfortable living room

F: huge filesize, ultra-detailed, highres, walking

N:EasyNegative, (worst quality, low quality:1.4)

以下が入力された状態です。

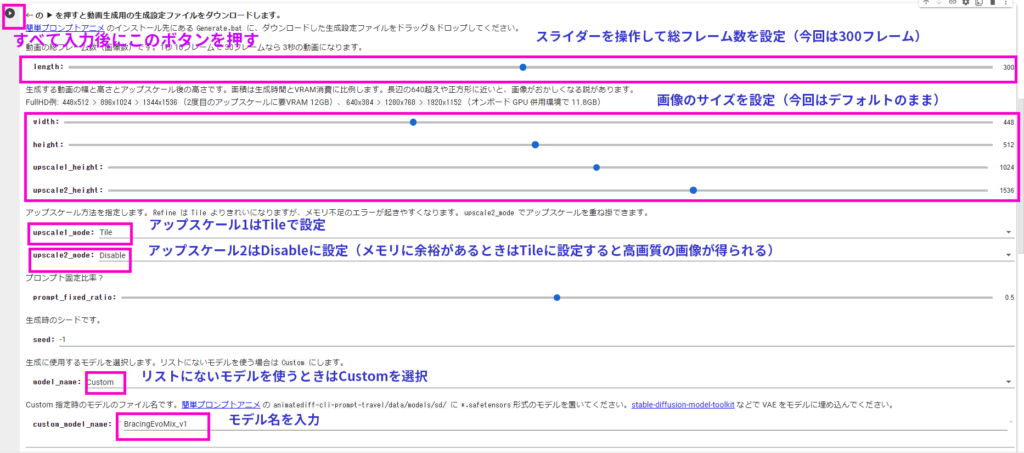

続いて、生成条件を設定します。

・フレーム数を設定します。今回は300フレームで設定しました。10フレーム1秒の計算です。

・動画の画面サイズを設定します。画像サイズは必要なメモリ量に効いてきます。ここではデフォルトの縦長の動画にします。

・アップスケール1はデフォルトのTileのままを設定します。

・アップスケール2は私のPCではVRAM10GBで多分メモリが足りないので、適用しません。

・モデルはcustomを設定して、下に「.safetensors」の拡張子を除いた部分を入力します。

・すべて入力したら、左上のボタンを押すとJSON形式の設定ファイルがダウンロードされます。

動画の生成

上記の設定ファイル生成を行うと「0924_2056_39-L300-C16-W448-H512-T1024.json」といったJSONファイルが生成します。ファイル名にも生成動画条件が含まれています。

生成月日-生成時間-L(総フレーム数)-C(context値)-W(動画幅)-H(動画高さ)-T(upscale後の高さ).json

直接JSONファイルを編集して生成条件を設定することは可能ですが、上記のファイル名にもご注意ください。

動画の生成は上記のJSONファイルを「animatediff-cli-prompt-travel」ファイルにドラッグすることで開始されます。

生成には条件によって数10分以上掛かりますので、待ちましょう。

生成が終わると、上記のプロンプトから生成した動画は「animatediff-cli-prompt-travel」の下の「output」(アップスケール前の動画)と「upscaled」(アップスケール後の動画)に保存されます。

今回生成した動画は以下の通りです。(BGMなどは別途後付けしています。)

その他の動画生成例

AI美女

AIアニメ

コメント